| GROK(xAI) | Modelo desenvolvido com foco em integração a produtos de rede social e interação em tempo real. Combina rapidez de resposta com suporte a conversas abertas e memes culturais. | Forte personalização em tom mais “humano e descontraído”. Bom para engajamento em plataformas sociais. | Menos orientado a aplicações empresariais críticas. Menor maturidade em ferramentas avançadas de integração. | Uso em interações de massa, chat em tempo real, engajamento em plataformas de consumo. |

| OpenAI GPT (série GPT-4.x / o-series) | Excelência em raciocínio geral, codificação, análise de dados e multimodalidade. Suporte avançado a function-calling, agentes e integrações. | Amplo ecossistema, suporte multimodal nativo (texto, imagem, áudio), alta precisão em benchmarks. | Custo elevado, dependência do serviço em nuvem, pouca liberdade de implantação local. | Corporações, desenvolvimento de produtos avançados, aplicações críticas de alto valor agregado. |

| Anthropic Claude 4 (Opus, Sonnet) | Foco em segurança, explicabilidade e raciocínio estendido. Oferece modos diferentes de resposta (mais rápido x mais profundo). | Melhor controle de complexidade, alinhamento ético e segurança reforçada. | Adoção mais recente no mercado, menor flexibilidade de customização local. | Empresas reguladas, cenários que exigem segurança e confiabilidade em decisões. |

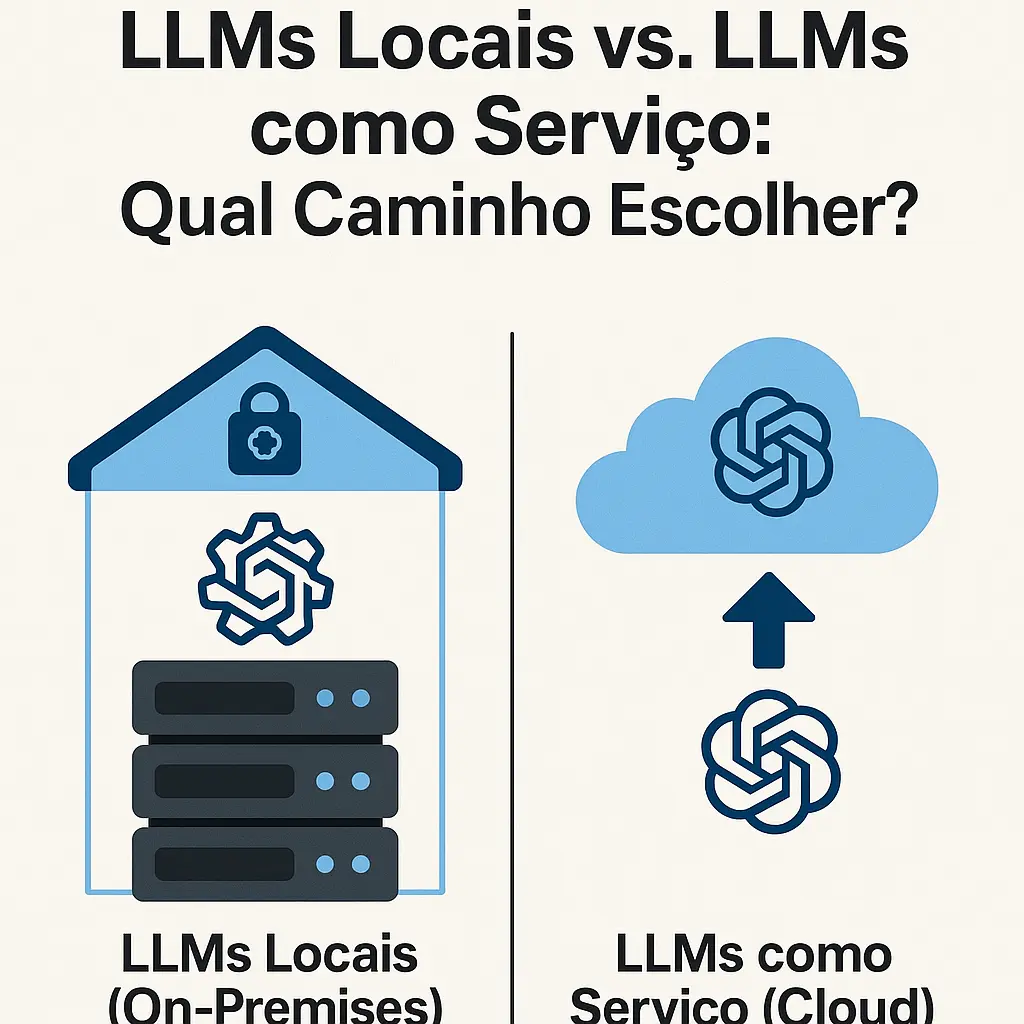

| Meta Llama 4 | Modelo aberto, disponível para execução local. Competitivo em benchmarks de linguagem geral, com suporte multimodal em versões avançadas. | Liberdade de uso, flexível para fine-tuning, ideal para ambientes on-premises. | Requer infraestrutura própria (GPUs), manutenção e otimização. | Empresas que buscam reduzir dependência de nuvem, P&D, aplicações que exigem controle de dados. |

| Mistral | Modelos menores, eficientes e rápidos, incluindo mixture of expertspara otimização de desempenho. | Custo-benefício, baixa latência, bom para integração em larga escala com menor consumo. | Não atinge o nível dos modelos SOTA em tarefas complexas. | Startups, aplicações de alto volume e uso intensivo com foco em economia. |

| DeepSeek | Modelos otimizados para tarefas específicas, com custo de inferência reduzido e boa performance em benchmarks de classificação e análise. | Excelente relação custo/performance em tarefas delimitadas. | Menor versatilidade em raciocínio aberto e multimodalidade. | Aplicações nichadas, análise estruturada, projetos com orçamento reduzido. |